百度蜘蛛抓取/*&%5E%25$和/*&^%$造成404错误的应急临时解决方案

本站使用的是程 序:Z-BlogPHP 1.5.2 Zero 正式版

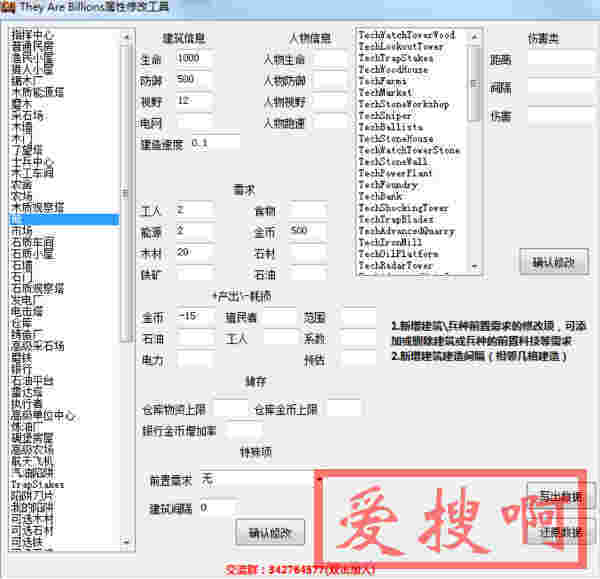

最近查看蜘蛛抓取记录发一个问题,如下图

就像上面这样,蜘蛛抓取的时候会在正常地址后面加上*&%5E%25$导致提示500状态码错误,抓取不成功。

自动在URL后添加参数/*&%5E%25$,转码后/*&^%$的造成抓取404。

但模拟百度蜘蛛UA抓取并不会出现该问题。

该问题导致网站收录量下降,影响网站流量。而网站流量是网站运营的命根。

在网上找到了下面这个说法,我感觉可能性比较大。

可能引起的原因

这不是百度蜘蛛,这是模拟的假的user-agent,我之前也被这样玩过,这是编码过的中文,发的广告,就是靠你网站的动态页面增加这个关键词的流量,甚至有的人直接在后面写链接

IP是百度蜘蛛的,可以通过ipip.net确认。

模拟百度蜘蛛抓取,不会出现此错误。

此问题大约升级到宝塔6.3后出现

可能宝塔防火墙有关系?存疑

此问题在百度站长论坛有多个帖子反馈,他们也是用的宝塔

此问题有比较大的概率和宝塔面板有关系,建议宝塔的管理员能检测一下。

我也没有找到出现此问题的根源,只能从百度方面来解决,解决办法是在robots.txt做了抓取屏蔽 Disallow: /*%5E%25*

Disallow: /*&* 然后在百度资源平台更新robots.txt,大约3天左右停止了抓取。

这是百度的蜘蛛。*&%5E%25$也不是编码过的中文,转码后是*&^%$,按住SHIFT,然后输入87654,就是这些符号。

就这几天,我的M站百度收录从600多页断崖式降到100多页(百度站长工具看的索引量)

你可以在百度站长工具Robots功能中检查一下Disallow: /*.html/*是否可以防止/*&%5E%25$和/*&^%$,以及是否影响了正常网页的抓取。因为我临时处理后

Disallow: /*%5E%25*

Disallow: /*&*

收录没受影响,可以抓取正常的网页,只是不在抓取/*&%5E%25$和/*&^%$了。

临时解决方法

应急方案:

将错误的URL写入robots.txt(这个方法不太好,禁止访问后,蜘蛛虽然不爬取,但是我们会因此忽略错误的存在)

301重定向,设置伪静态规则:rewrite ^/([0-9]+)/([0-9]+).html/(.*) /$1/$2.html permanent;(NGINX规则)APCHE规则:RedirectMatch 301 ^/(\d+)/(\d+)\.html/(.*)$ /$1/$2.html

特别提醒

上述伪静态规则仅针对/([0-9]+)/([0-9]+).html/*&%5E%25$的错误有效。

对于根目录下的/*&%5E%25$或二级目录下的/A/*&%5E%25$错误,需另写伪静态规则。

因为包含了特殊字符,我也不知道如何匹配写法,希望看到的大神帮个忙,在此表示感谢!

本站附件分享,如果附件失效,可以去找找看